0

发表咨询在线!

摘要: 针对卫星天线模块自动化精密装配需求,介绍一种基于机器视觉的机器人自动精密装配方法。通过 6 自由度工业机器人和相机建立 Eye-in-Hand 和 Eye-to-Hand 混合的自动装配系统,对系统进行手眼标定,从而确定相机、机器人、工具之间的相互位置关系,通过图像处理获取装配位置像素坐标,并通过坐标变换将像素坐标点转换为机器人基坐标点,控制机器人完成天线模块自动装配。装配时通过 Eyeto-Hand 和 Eye-in-Hand 系统分别直接定位天线模块上连接器公头和母头位置,消除连接器安装位置误差和模块外壳加工尺寸误差对定位精度的影响,该系统通过一次标定即可实现机器人末端工具在距目标物体垂直距离相同情况下 X /Y 任意位置的定位功能。实验结果证明该方法准确可行,所设系统满足 50 μm 装配公差天线模块的自动精密装配要求。

关键词: 机器视觉; 目标定位; 手眼标定; 卫星天线装配; 机器人

卫星天线作为星间链路核心装备,具有装配尺寸精度高、星载模块小巧紧凑、装配工序烦琐等特点[1],因此,现阶段主要采用人工进行装配,装配精度及一致性差,产品质量难管控[2]。随着近几年国内外卫星部署战略的不断推进,卫星需求数量不断增加,卫星制造逐步由单件生产模式向批量生产模式发展[3],传统手工装配方式无论从质量上还是效率上均无法满足要求,因此亟需将自动精密装配技术引入到卫星等航天产品的装调过程中,以提高产品的装配质量和效率。

目前,国外卫星天线装配基本实现自动化、数字化,其中 Orbital ATK 公司建造的一条具有 18 个工作站的卫星生产线,实现了一周装配一颗卫星的生产水平[4]。国内主要针对部分特定型号天线进行了自动化装配尝试,但设备普遍具有通用性低、操作烦琐、柔性差等不足[5 - 6]。在自动化精密装配方面,目前基于机器视觉的工业机器人自动装配系统大多为 Eye-toHand [7 - 8]系统,应用于工件抓取一致性好或装配目标点不变的情况下[9 - 10]。另外,为保证装配精度等因素,系统中执行机构多选用直角坐标机器人或 SCARA 机器人[11],降低了系统的灵活性以及角度调节能力。文献[12]将深度学习方法引入到机器人物体识别与抓取中,该方法适用于复杂场景中的物体识别与抓取,但定位精度和成功率较低,目前在工业现场工件精密装配场景中还未广泛应用。文献[13]针对卫星大型部件装配提出一种基于力 - 位混合控制的机械臂辅助装配方法,在工件接触后通过力 - 位关系实时对工件位置进行调整,该方法需针对每种产品摸索其对应的力 - 位关系曲线,要求系统具有较高的实时性,装配耗时较长。文献[14]提出一种基于数据配准的工件配合表面最佳接触状态确定方法,该方法在装配前需要获取工件精确的三维模型,装配时需要实时获取工件的相对位置关系,不适合于接触面复杂的细针孔类工件的装配,且成本高、效率低。文献[15]提出了基于 6 自由度机器人和激光跟踪仪的闭环控制装配系统,该系统定位精度高,但在装配前需要人工放置靶标,在运行过程中需要根据产品尺寸合理规划运动路径、考虑遮挡及测量范围等因素,因此操作烦琐,通用性差。

本文对基于机器视觉[16 - 17]的 6 自由度机器人自动装配技术进行了研 究,针对相控阵天线 T /R 模块[18]装配精度高、尺寸一致性差等特点,建立了 Eyein-Hand [19]和 Eye-to-Hand [7]混合的自动装配系统,两系统共用同一台六轴工业机器人,通过像素坐标系、相机坐标系、工具坐标系、机器人基坐标系之间的相互转换,实现系统整体坐标系统一。装配过程中,通过工业相机获取工件图像,通过 OpenCV 开源库[20]对图像进行分析处理从而确定工件在像素坐标系中的位置坐标,利用坐标变换将像素坐标转换为机器人基坐标,并将坐标信息发送给机器人控制器,机器人手臂执行装配动作,并最终在 Visual Studio 2013 平台下完成对整套系统控制软件程序的开发。

1 系统总体设计

天线模块 A 和模块 B 外表如图 1 所示,装配时需将模块 A 通过连接器装配到模块 B 上。

装配系统硬件平台如图 2 所示,机器人和相机Ⅱ 固定安装在基座平台上,相机Ⅰ和抓取工具安装在机器人末端法兰盘上,天线模块通过托盘在传送链上运送到指定位置后,通过相机拍照并进行图像处理获取模块 A、模块 B 的像素位置坐标,然后通过坐标变换将像素坐标转换为机器人坐标位置,最终机器人抓取模块 A 并将其装配到模块 B 上。由于连接器在模块上的安装存在位置误差及模块外壳加工存在尺寸误差,因此在装配时通过相机Ⅱ对抓起后的模块 A 进行定位,通过相机Ⅰ对模块 B 进行定位,定位位置均直接为连接器中心。

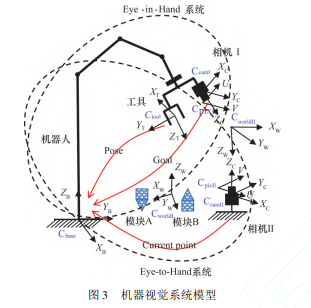

系统模型如图 3 所示,其中相机Ⅰ与机器人、末端工具组成 Eye-in-Hand 系统,相机Ⅱ与机器人、末端工具组成 Eye-to-Hand 系统,模块 A 和模块 B 为待装配的天线部件。Cbase为机器人基坐标系,Ctool为机器人末端工具坐标系,CcamⅠ 和 CcamⅡ 分别为相机Ⅰ和相机Ⅱ 的相机坐标系,CpixⅠ和 CpixⅡ分别为相机Ⅰ和相机Ⅱ的像素坐标系,CworldⅠ和 CworldⅡ分别为相机Ⅰ和相机Ⅱ标定时的世界坐标系。

系统装配过程及坐标变换如下。

首先机器人带动相机Ⅰ移动到模块 A 上方对其进行拍照以确定抓取位置。通过图像处理获取模块 A 在 CpixⅠ中的坐标 PPartA_Up_In_PixⅠ; 对 PPartA_Up_In_PixⅠ 进行坐标变换得到模块 A 在 CcamⅠ下的坐标 PPartA_Up_In_CamⅠ; 通过 PPartA_Up_In_CamⅠ 和相机Ⅰ在 Ctool 下的坐标 PCamⅠ_In_Tool 可以得到模块 A 在 Ctool 下的坐标 PPartA_Up_In_Tool ; 通过 PPartA_Up_In_Tool 和机器人末端工具在 Cbase 下 的 坐 标 PTool_In_Base 可 以 得 到 模 块 A 在 Cbase 下 的 坐 标 PPartA_Up_In_Base ; 通过 PPartA_Up_In_Base即可控制机器人移动到目标点 PRobot_Aim_Catch对模块 A 进行抓取。

机器人抓取模块 A 后移动到相机Ⅱ上方对其底端连接器进行拍照以确定模块 A 的装配位置。通过图像处理获取模块 A 在 CpixⅡ中的坐标 PPartA_Down_In_PixⅡ; 对 PPartA_Down_In_PixⅡ进行坐标变换得到模块 A 在 CcamⅡ 下的坐标 PPartA_Down_In_CamⅡ; 通过 PPartA_Down_In_CamⅡ 和相机Ⅱ 在 Cbase下的坐标 PCamⅡ_In_Base可以得到模块 A 的装配点在基坐标系下的坐标 PPartA_Down_In_Base。

确定模块 A 的装配位置后,机器人带动相机Ⅰ移动到模块 B 上方对其连接器进行拍照以确定模块 B 的装配位置,坐标转换过程与确定模块 A 抓取位置相同,最终得到模块 B 在 Cbase下的坐标 PPartB_In_Base。根据 PPartB_In_Base和 PPartA_Down_In_Base 控制机器人移动到目标点 PRobot_Aim_Assem对模块 A 和模块 B 进行装配。

上 述 坐 标 变 换 过 程 如 图 4 所 示。 其 中 PPartA_Up_In_PixⅠ 到 PPartA_Up_In_CamⅠ、 PPartA_Down_In_PixⅡ 到 PPartA_Down_In_CamⅡ及 PPartB_In_PixⅠ 到 PPartB_In_CamⅠ 的变换可通过相机内外参标定实现; PTool_In_Base可通过机器人工具标定获得,PCamⅠ_In_Tool可通过 Eye-in-Hand 系统标定获得; PCamⅡ_In_Base可通过 Eye-to-Hand 系统标定获得。

2 天线模块图像处理与位置识别

天线模块图像处理主要是确定连接器中心位置像素坐标,图像处理过程包括颜色空间转换、阈值分割、区域连通、边缘提取、圆拟合、直线拟合、求取中心点等。

以天线模块 A 为例,待处理图像如图 5 所示,通过连接器中 15 根插针确定模块位置。

首先对图像进行预处理,在原图上粗略截取感兴趣区域( Region Of Interest,ROI) ,然后将 ROI 由 RGB 空间转换到 HSV( Hue,Saturation,Value) 空间,并对特征明显的 S 通道图像进行阈值分割,分割时采用动态阈值分割法以减小光线变化的影响。对阈值分割后的图像进行开运算以及膨胀等形态学操作以消除微小噪声并填充轮廓区域,对轮廓进行筛选后可得到连接器区域,图像预处理过程如图 6 所示。

相关知识推荐:论文重复率0好发表吗

以得到的连接器区域为蒙版在原图 G 通道上截取精确的 ROI 区域,并对该区域进行锐化以强化特征,对锐化后的图像进行基于 Canny 算子的亚像素轮廓提取,并对轮廓进行筛选最终可得到 15 根插针的外形轮廓,对轮廓进行圆拟合可得到 15 组轮廓中心坐标,通过坐标平均即可计算出连接器中心位置像素坐标,通过 15 组坐标数据进行最小二乘直线拟合即可得到连接器角度,图像处理过程如图 7 所示。

3 坐标系标定及转换

3. 1 相机内外参标定

首先进行相机内外参标定以对相机进行校准,其 标定模型[21]如图 8 所示,先通过标定板上已知点确定相机的内参数( 焦距、主点、比例因子、畸变系数等) 和外参数( 平移参数和旋转参数) ,然后即可通过内外参数确定像素坐标系下任意点 P'与其在世界坐标系下对应点 P 的坐标转换关系[22]:

相机Ⅰ标定时各部分相对位置关系如图 9 所示,标定板固定在平台上,机器人带动相机Ⅰ对标定板进行拍照获取图像进行标定。

为保证标定的准确性,应尽量控制机械臂带动相机以不同姿态对标定板进行拍照,每幅图像中标定板图像一般占整幅图像的 1 /3 左右[23],并最终使标定板覆盖整幅图像,标定图像如图 10 所示,标定结果如表 1、表 2 所示,标定误差( 角点重投影误差) 为 0. 1937 px。

相机Ⅱ标定时各部分相对位置关系如图 11 所示,标定板固定在机器人末端,机器人带动标定板运动到不同位姿,相机Ⅱ对标定板进行拍照获取图像进行标定。标定结果如表 3、表 4 所示,标定误差( 角点重投影误差) 为 0. 1583 px。

3. 2 六轴机器人末端工具标定

机器人工具标定模型[24]如图 12 所示,末端工具标定的目的即为确定工具坐标系到机器人基坐标系的转换关系。

3. 3 手眼标定

机器视觉系统手眼标定的目的是为了获取相机坐标系与机器人坐标系之间的转换关系。通常根据相机与机器人之间的位置关系不同可将机器人视觉系统分为 Eye-in-Hand 系 统 和 Eye-to-Hand 系 统[26]。其 中, Eye-in-Hand 系统是将相机固定在机器人法兰盘末端,工作时相机随机器人一起运动; Eye-to-Hand 系统是将相机安装固定在机器人本体外,工作时相机不随机器人运动[27]。在机器人移动过程中,Eye-in-Hand 系统中相机坐标系相对于机器人末端法兰坐标系( 或机器人工具坐标系) 的位置关系是不变的,Eye-to-Hand 系统中相机坐标系相对于机器人基坐标系的位置关系是不变的,这是进行手眼系统标定的重要依据。

3. 3. 1 Eye-in-Hand 系统标定

Eye-in-Hand 系统手眼标定模型[28]如图 14 所示,其中 Cbase为机器人基坐标系,Ctool为机器人末端工具坐标系,Ccam为相机坐标系,Cobj为标定板坐标系。

标定时,标定板固定不动,控制机器人带动相机运动到不同位姿对标定板进行拍照,每次标定出当前位姿下相机与标定板的位置关系( 相机外参数) ,同时根据机器人末端工具的位姿最终计算得到相机坐标系到机器人末端工具坐标系的变换矩阵,其中机器人末端工具的位姿可通过机器人六点工具标定获得。机器人运动前后相机坐标系、末端工具坐标系及标定板坐标系相对位置变化如图 15 所示。

4 结束语

本文介绍的基于机器视觉的卫星天线模块自动精密装配技术,完成了相机内外参标定、机器人末端工具标定、Eye-in-Hand 系统手眼标定、Eye-to-Hand 系统手眼标定,根据采集到的图像信息,经过图像处理和坐标变换得到机器人的目标位姿,并通过以太网将数据传输到机器人控制系统,实现了对天线模块的自动精密装配。经实验验证,系统满足 50 μm 装配公差天线模块的自动精密装配要求,实验结果达到预期要求,且该技术已成功应用于航天领域高精密复杂卫星产品的自动化装配中,由此证明所提出的基于机器视觉的卫星天线模块自动精密装配技术具有较强的实用价值。——论文作者:闫俊杰,王红伟,于功敬,张忠海

参考文献:

[1] 常文凯,胡龙飞,陈冬宇,等. 有源相控阵雷达天线结构设计[J]. 机械与电子,2019,37( 7) : 33 - 37.

[2] 吕鹏,范乃康,李成国,等. 星载模块式相控阵天线整机集成装置设计[C]/ / 2019 年全国天线年会论文集( 中册) . 2019.

[3] 付佐红. 自动化技术在卫星天线高精度装配中的运用探讨[J]. 科技创新导报,2020,17( 3) : 125 - 126.

[4] 赵相禹. 卫星智能化装配系统 发展现状及关键技术[J].国际太空,2020( 3) : 59 - 63.

[5] 黎田,胡晓雪,姚为,等. 机器人在航天装备自动化装配中的应用研究[J]. 航空制造技术,2014( 21) : 102 - 104.

[6] 魏乐愚,杨宏青,荣田. 自动对接装配技术在航天产品对接装配中的应用研究[J]. 航天制造技术,2011( 5) : 42 - 44.

[7] ANDREFF N,HOROUD R,ESPIAU B. Robot hand-eye calibration using structure-from-motion[J]. The International Journal of Robotics Research,2001,20( 3) : 228 - 248.

[8] TABB A,YOUSEF K M A. Solving the robot-world hand-eye ( s) calibration problem with iterative methods[J]. Machine Vision and Applications,2017,28( 5 /6) : 569 - 590.

[9] WANG W Q,LUO Y,YANG K,et al. Multi-angle automotive fuse box detection and assembly method based on machine vision[J]. Measurement,2019,145: 234 - 243.

[10] 刘晓鹏,刘波,马自超,等. 基于机器视觉的遥控器装配系统研究与设计[J]. 自动化仪表,2017,38 ( 11) : 92 - 95

[11] 张明建,曾伟明. 基于机器视觉的小型电机自动装配研究[J]. 制造技术与机床,2017( 6) : 124 - 128.

[12] VIJAYAN A T,SANKAR A,SUDHEER A P. A comparative study on the performance of neural networks in visual guidance and feedback applications[J]. Automatika,2017, 58( 3) : 336 - 346.

[13] 刘仁伟,徐晓辉,谢永权,等. 基于机械臂辅助的卫星柔顺装配技术研究[J]. 机电工程,2020,37( 5) : 532 - 536.

[14] 张体广,张发平,阎艳,等. 基于数据配准的零件精密装配最佳接触状态研究[J]. 兵工学报,2018,39( 1) : 127 - 136.

* 稍后学术顾问联系您